Компания Clearpath Robotics была основана шесть лет назад тремя друзьями по колледжу, которых объединила страсть делать всякие штуки. 80 специалистов компании испытывают роботов для движения по пересеченной местности вроде Husky, четырехколесного робота, используемого минобороны США.

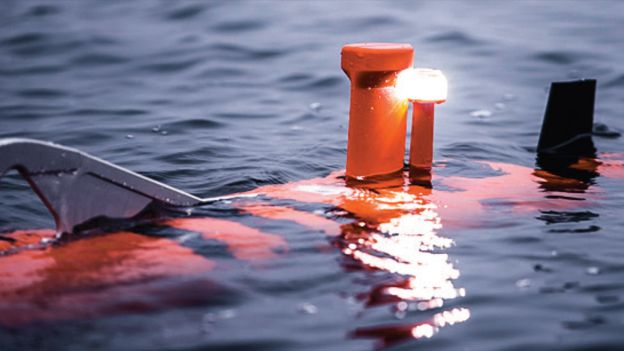

Также они делают дронов и даже построили роботизированную лодку Kingfisher. Однако одного они точно никогда не построят: робота, который может убивать.

Clearpath является первой и пока единственной компанией по производству роботов, которая пообещала не создавать роботов-убийц. Решение было принято в прошлом году соучредителем и CTO компании Райаном Гарипаем и по факту даже привлекло в компанию экспертов, которым понравилась уникальная этическая позиция Clearpath.

Husky

Этика компаний, производящих роботов, в последнее время выходит на передние позиции. Видите ли, мы одной ногой в будущем, в котором будут существовать роботы-убийцы. И мы пока совершенно не готовы к ним.

Конечно, впереди еще длинный путь. Корейская Dodam systems, например, строит автономную роботизированную турель под названием Super aEgis II. Она использует тепловизионные камеры и лазерные дальномеры для выявления и атаки целей на расстоянии до 3 километров. США, судя по сообщениям, тоже экспериментируют с автономными ракетными системами.

В двух шагах от «терминаторов»

Военные беспилотники вроде Predator в настоящее время управляются людьми, но Гарипай говорит, что очень скоро они станут полностью автоматическими и автономными. И это беспокоит его. Очень. «Смертоносные автономные системы оружия могут сойти с конвейера уже сейчас. Но смертоносные оружейные системы, которые будут делаться в соответствии с этическими нормами, — их нет даже в планах».

Для Гарипая проблема заключается в международных правах. На войне всегда бывают ситуации, в которых применение силы кажется необходимым, но оно также может подвергнуть опасности невинных прохожих. Как создать роботов-убийц, которые будут принимать правильные решения в любой ситуации? Как нам определить самостоятельно, каким должно быть правильное решение?

Подобные проблемы мы уже наблюдаем на примере автономного транспорта. Допустим, собака перебегает дорогу. Должен ли робот-автомобиль свернуть, чтобы не сбить собаку, но подвергнуть риску своих пассажиров? А если это не собака, а ребенок? Или автобус? Теперь представьте зону боевых действий.

«Мы не можем договориться о том, как написать руководство по эксплуатации такого автомобиля, — говорит Гарипай. — А теперь мы еще и хотим перейти к системе, которая должна самостоятельно решать, применять ей смертоносную силу или нет».

Делайте крутые штуки, а не оружие

Питер Асаро провел последние несколько лет, лоббируя запрет на роботов-убийц в международном сообществе, будучи основателем Международного комитета по контролю роботизированных армий. Он считает, что пришло время для «четкого международного запрета на их развитие и использование». По его словам, это позволит компаниям вроде Clearpath продолжать делать классные штуки, «не переживая, что их продукты могут быть использованы для нарушения прав людей и угроз мирным жителям».

Автономные ракеты интересны военным, потому что они решают тактическую задачу. Когда беспилотники с дистанционным управлением, например, работают в боевых условиях, противник нередко заглушает датчики или сетевое соединение, чтобы человек-оператор не мог видеть, что происходит, или управлять дроном.

Гарипай говорит, что вместо разработки ракет или дронов, которые могут самостоятельно решать, какую цель атаковать, военным нужно тратить деньги на улучшение датчиков и защиты от заглушения технологий.

«Почему бы нам не взять инвестиции, которые люди хотели бы вложить для постройки автономных роботов-убийц, и не вложить их в повышение эффективности существующих технологий? — говорит он. — Если мы поставим задачу и преодолеем этот барьер, мы сможем заставить эту технологию работать на благо людей, не только военных».

В последнее время также участились разговоры об опасности искусственного интеллекта. Элон Маск беспокоится, что вышедший из-под контроля ИИ может уничтожить жизнь, какой мы ее знаем. В прошлом месяце Маск пожертвовал 10 миллионов долларов на исследования в области искусственного интеллекта.

Один из важных вопросов о том, как ИИ повлияет на наш мир, заключается в том, как он сольется с робототехникой. Некоторые вроде исследователя из Baidu Эндрю Нг беспокоятся, что грядущая революция ИИ отнимет у людей работы. Другие вроде Гарипая опасаются, что может отнять и жизни.

Гарипай надеется, что его коллеги, ученые и строители машин задумаются о том, что делают. Потому и Clearpath Robotics приняла сторону людей. «Хотя мы, как компания, не можем поставить на это 10 миллионов долларов, но мы можем поставить нашу репутацию».

📰 Источник ©

Если вы видели что-то необычное, пришлите историю нам через форму обратной связи или на адрес newsparanormal@yandex.ru и мы опубликуем ее на этом сайте.